“5.1算法原理”的版本间的差异

来自CloudWiki

| 第10行: | 第10行: | ||

[[文件:AIred003.jpg]] | [[文件:AIred003.jpg]] | ||

| + | |||

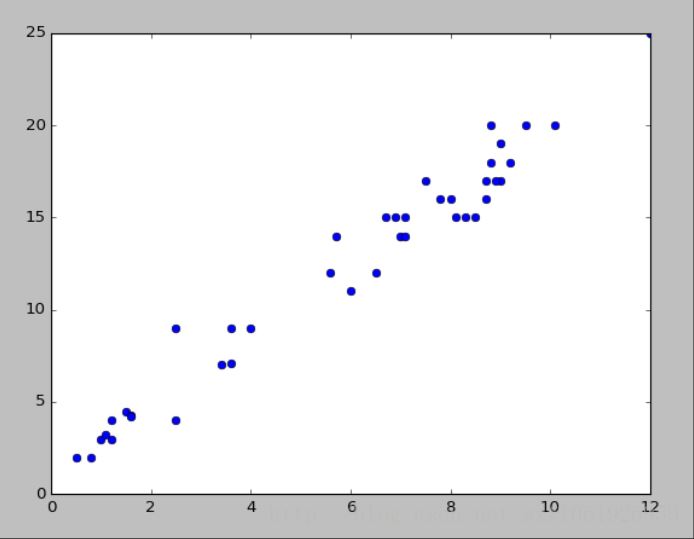

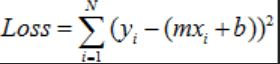

| + | 如上图所示,横坐标表示x,纵坐标表示y。我们要找的就是图中的这条直线。我们要去找到这条直线,大家可以想象,我们肯定希望找到的那条线,距离每个点都很近,最好所有的点上都在这条线上,但是一条直线去拟合所有的点都在这条直线上肯定不现实,所以我们希望这些点尽量离这条直线近一点。即去找每个点和直线的距离 [[文件:AIred004.jpg]] 最小的那条线,为了简单起见,将绝对值转化为平方,那么误差可以表示为[[文件:AIred005.jpg]] ,这里i表示第i个数据,N表示总的样本个数。一般我们还会把Loss求和平均,来当作最终的损失,即 [[文件:Aired006.jpg]] | ||

2018年5月28日 (一) 13:40的版本

线性回归是机器学习中最基本的一个算法,但是那些所谓的效果很好的算法也无非是从这些基础算法慢慢演变而来。 线性回归包括一元线性回归和多元线性回归,一元的是只有一个x和一个y。多元的是指有多个x和一个y。

下面我只讲下一元的,多元只是将y=mx+b 变成了y=m1x1+m2b2+b 一元线性回归其实就是去找到一条直线,这条直线能以最小的误差(Loss)来拟合数据。

怎么来表示误差呢?

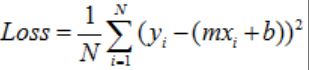

如上图所示,横坐标表示x,纵坐标表示y。我们要找的就是图中的这条直线。我们要去找到这条直线,大家可以想象,我们肯定希望找到的那条线,距离每个点都很近,最好所有的点上都在这条线上,但是一条直线去拟合所有的点都在这条直线上肯定不现实,所以我们希望这些点尽量离这条直线近一点。即去找每个点和直线的距离 ![]() 最小的那条线,为了简单起见,将绝对值转化为平方,那么误差可以表示为

最小的那条线,为了简单起见,将绝对值转化为平方,那么误差可以表示为 ,这里i表示第i个数据,N表示总的样本个数。一般我们还会把Loss求和平均,来当作最终的损失,即

,这里i表示第i个数据,N表示总的样本个数。一般我们还会把Loss求和平均,来当作最终的损失,即