“Slave1上安装hive”的版本间的差异

来自CloudWiki

201708010242(讨论 | 贡献) (→启动hive服务) |

(→修改 hive-env.sh) |

||

| (未显示2个用户的3个中间版本) | |||

| 第1行: | 第1行: | ||

| + | |||

| + | == hive在hadoop中的位置 == | ||

| + | |||

| + | [[文件:QQ截图20181119102043.png]] | ||

== 解压hive文件 == | == 解压hive文件 == | ||

| 第8行: | 第12行: | ||

| − | #set hive | + | <nowiki>#set hive |

export HIVE_HOME=/usr/hive/apache-hive-2.1.1-bin | export HIVE_HOME=/usr/hive/apache-hive-2.1.1-bin | ||

| − | export PATH=$PATH:$HIVE_HOME/bin | + | export PATH=$PATH:$HIVE_HOME/bin</nowiki> |

== 拷贝Mysql 的 lib 安装包 == | == 拷贝Mysql 的 lib 安装包 == | ||

| 第23行: | 第27行: | ||

回到 slave1,修改 hive-env.sh 中 HADOOP_HOME 环境变量 | 回到 slave1,修改 hive-env.sh 中 HADOOP_HOME 环境变量 | ||

| − | + | <nowiki>HADOOP_HOME=/usr/hadoop/hadoop-2.7.3</nowiki> | |

| − | |||

| − | |||

== 修改 hive-site.xml == | == 修改 hive-site.xml == | ||

| 第57行: | 第59行: | ||

<property> | <property> | ||

<name>hive.metastore.schema.verification</name> | <name>hive.metastore.schema.verification</name> | ||

| − | + | <value>false</value> | |

</property> | </property> | ||

<property> | <property> | ||

| 第65行: | 第67行: | ||

</configuration> | </configuration> | ||

</nowiki> | </nowiki> | ||

| − | |||

== 启动hive服务 == | == 启动hive服务 == | ||

2018年11月20日 (二) 06:01的最新版本

目录

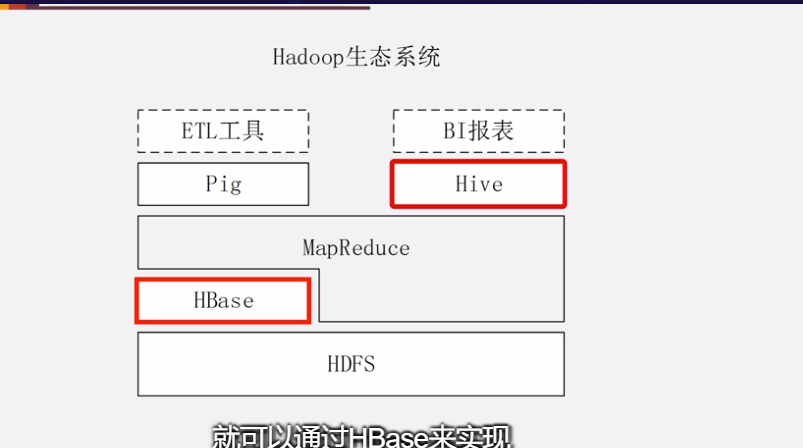

hive在hadoop中的位置

解压hive文件

.

修改/etc/profile 文件

首先我们需要创建工作路径,并将 hive 解压。环境中 master 作为客 户端,slave1 作为服务器端,因此都需要使用到 hive。因为 hive 相关安装包存 放在 master 中,因此我们先在 master 中对 hive 进行解压,然后将其复制到 slave1 中。

#set hive export HIVE_HOME=/usr/hive/apache-hive-2.1.1-bin export PATH=$PATH:$HIVE_HOME/bin

拷贝Mysql 的 lib 安装包

shell远程连slave2 把mysql-connector-java-5.1.5-bin.jar考到slave1 的 hive 的 lib 中

修改 hive-env.sh

回到 slave1,修改 hive-env.sh 中 HADOOP_HOME 环境变量

HADOOP_HOME=/usr/hadoop/hadoop-2.7.3

修改 hive-site.xml

删除全部内容,添加以下内容

<?xml version="1.0" encoding="UTF-8" standalone="no"?> <?xml-stylesheet type="text/xsl" href="configuration.xsl"?> <configuration> <property> <name>hive.metastore.warehouse.dir</name> <value>/user/hive_remote/warehouse</value> </property> <property> <name>javax.jdo.option.ConnectionURL</name> <value>jdbc:mysql://slave2:3306/hive?createDatabaseIfNotExist=true</value> </property> <property> <name>javax.jdo.option.ConnectionDriverName</name> <value>com.mysql.jdbc.Driver</value> </property> <property> <name>javax.jdo.option.ConnectionUserName</name> <value>root</value> </property> <property> <name>javax.jdo.option.ConnectionPassword</name> <value>123456</value> </property> <property> <name>hive.metastore.schema.verification</name> <value>false</value> </property> <property> <name>datanucleus.schema.autoCreateAll</name> <value>true</value> </property> </configuration>

启动hive服务

进入hive的目录,在hive的目录下输入

bin/hive --service metastore