“大数据生态组件搭建”的版本间的差异

来自CloudWiki

(创建页面,内容为“理论知识: 1.HDFS分布式存储 是Hadoop项目的核心子项目,分布式计算中数据存储管理的基础,具有高容错,高可靠,高可扩展…”) |

|||

| 第2行: | 第2行: | ||

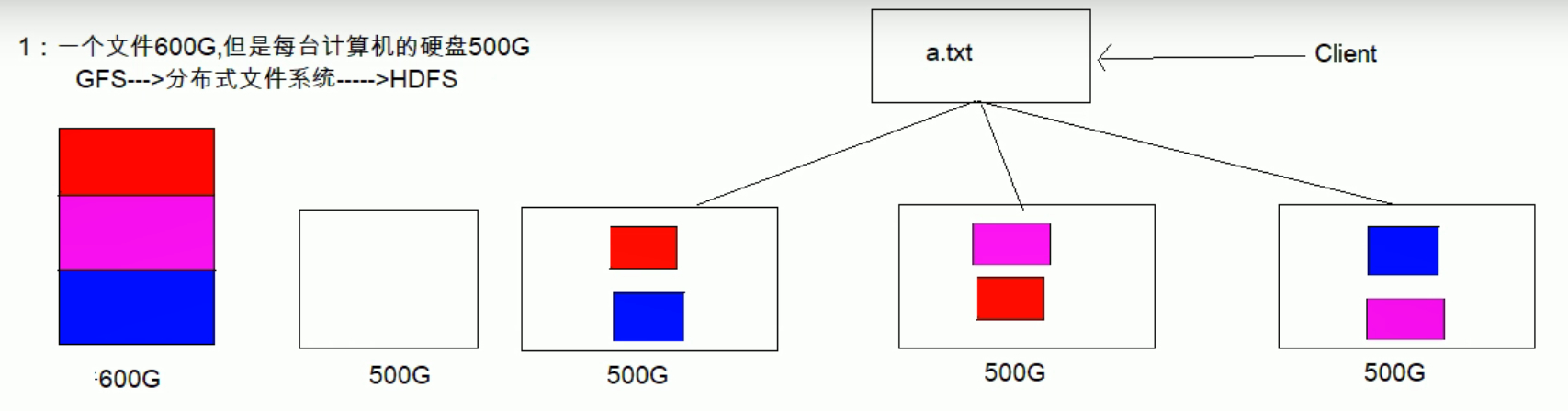

1.HDFS分布式存储 是Hadoop项目的核心子项目,分布式计算中数据存储管理的基础,具有高容错,高可靠,高可扩展,高吞吐率等 为海量数据提供了不怕故障的存储 | 1.HDFS分布式存储 是Hadoop项目的核心子项目,分布式计算中数据存储管理的基础,具有高容错,高可靠,高可扩展,高吞吐率等 为海量数据提供了不怕故障的存储 | ||

比如一个文件是100G,有三台电脑,HDFS会将100G的文件进行切片默认128MB存储到不同的计算机上,多副本,提高容错率,哪怕一台电脑宕机也不会影响数据的完整性 | 比如一个文件是100G,有三台电脑,HDFS会将100G的文件进行切片默认128MB存储到不同的计算机上,多副本,提高容错率,哪怕一台电脑宕机也不会影响数据的完整性 | ||

| + | |||

| + | [[文件:2020-11-07 184425.jpg]] | ||

2020年11月7日 (六) 10:47的最新版本

理论知识: 1.HDFS分布式存储 是Hadoop项目的核心子项目,分布式计算中数据存储管理的基础,具有高容错,高可靠,高可扩展,高吞吐率等 为海量数据提供了不怕故障的存储

比如一个文件是100G,有三台电脑,HDFS会将100G的文件进行切片默认128MB存储到不同的计算机上,多副本,提高容错率,哪怕一台电脑宕机也不会影响数据的完整性