上传文件到HDFS目录

实训目标

(1) 了解 HDFS 文件系统

(2) 掌握 HDFS 文件的基本操作。

实训环境

(1) 使用 CentOS 6.10 的 Linux 操作系统搭建的 3 个节点的 Hadoop 集群。

(2) 使用 1.8 的 JDK 。

(3) 使用 2.6.4 版本的 Hadoop 。

实训内容

(1) 在集群服务器(master )的终端,执行HDFS 命令,上传email_log.txt 到HDFS 目录/user/root/ 。

实训步骤

前置步骤

(1) 在Linux 终端执行命令“$HADOOP_HOME/sbin/start-all.sh ”,或双击桌面上名称为“hadoop ”的图标,启动hadoop 集群。

(2) 在Linux 终端执行命令“wget -P /opt/data http://datasrc.tipdm.net:81/bigdata/hadoop/data/email_log.zip ”,下载数据email_log.zip 到Linux 本地/opt/data 目录。

[root@master ~]# cd /opt [root@master opt]# mkdir data [root@master opt]# cd data [root@master data]# wget -P /opt/data http://datasrc.tipdm.net:81/bigdata/hadoop/data/email_log.zip

(4) 在Linux 终端执行命令“unzip /opt/data/email_log.zip -d /opt/data/ ”,将数据压缩包解压。

上传 email_log.txt 到 HDFS 目录 /user/root/

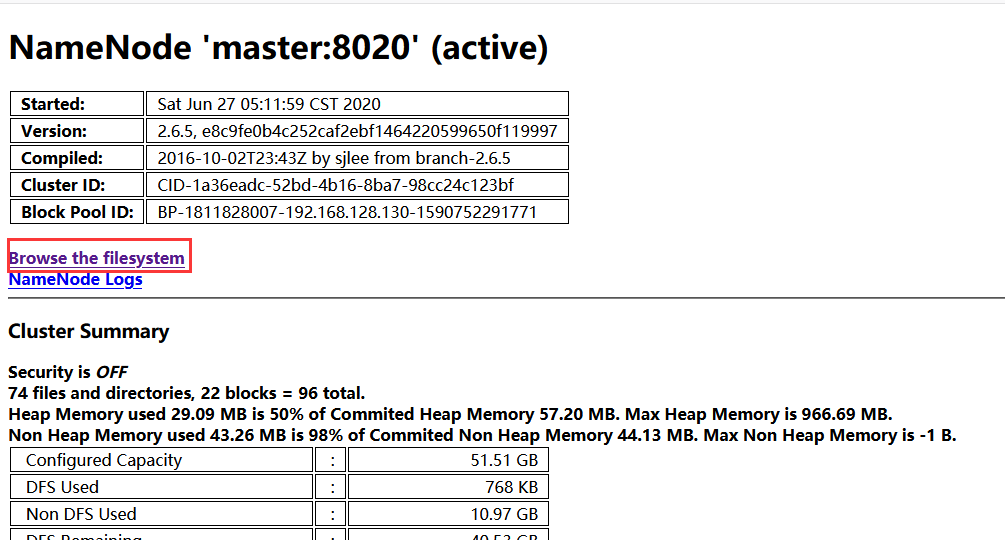

在命令终端执行命令 “hdfs dfs -mkdir -p /user/root” 创建 HDFS 上的目录 /user/root 。运行命令后查看 http://master:50070/dfshealth.jsp ,如 图 4 ‑1 所示。

图 4 ‑ 1 网页显示

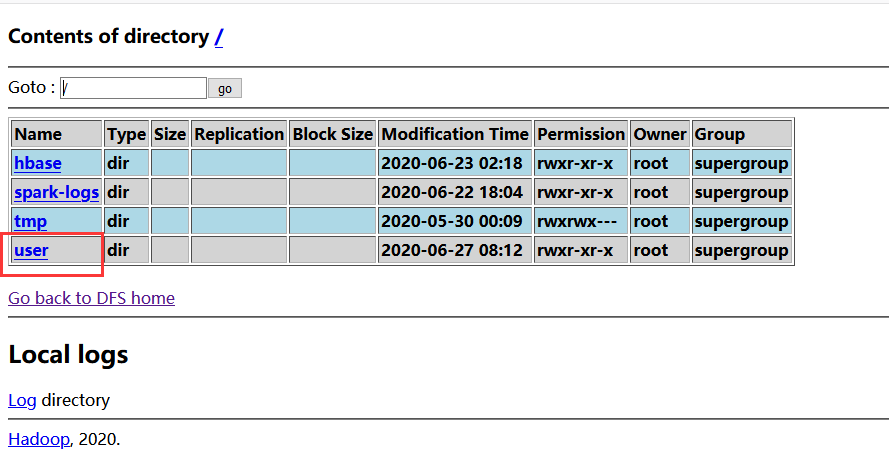

(2) 点击页面上的蓝色字体“ Browse the filesystem ”,在 HDFS 上查看创建的 /user/root 目录结构,如 图 4‑2 所示,也可通过 http://master:50070/nn_browsedfscontent.jsp 直接进入。

图 4 ‑ 2 HDFS 文件系统

(3) 在集群服务器( master )的终端,执行 HDFS 命令,上传 /opt/data/email_log.txt 到 HDFS 目录 /user/root/ 。具体命令如 代码 4-1 所示。

代码 4 - 1 上传文件到 HDFS 命令

hdfs dfs -put /opt/data/email_log.txt /user/root/

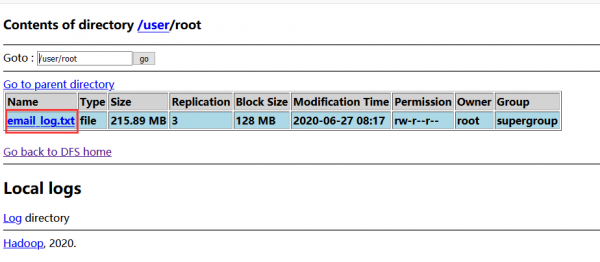

检查 HDFS 目录 /user/root/ ,如 图 4‑3 所示,文件 email_log.txt 上传成功。

图 4 ‑ 3 检查 HDFS 目录 /user/root/

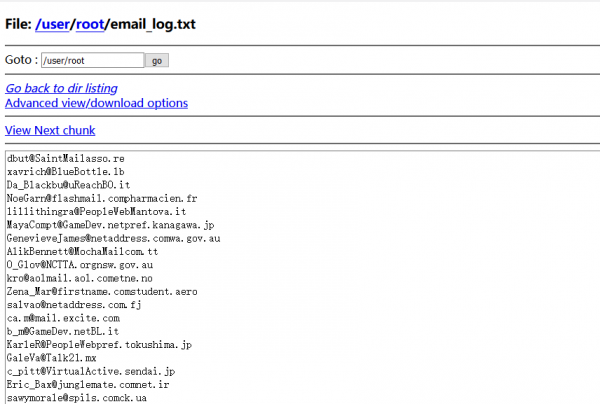

继续单击文件名 email_log.txt ,检查文件的内容,如 图 4‑4 所示。

图 4 ‑ 4 检查文件 email_log.txt 内容

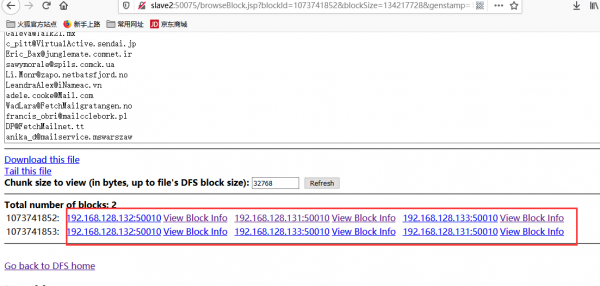

继续下拉当前页面到底部,如 图 4‑5 所示,文件 email_log.txt 被分割为两个文件块进行存储。

图 4 ‑ 5 检查文件 email_log.txt 的文件块信息