大数据案例构思

来自CloudWiki

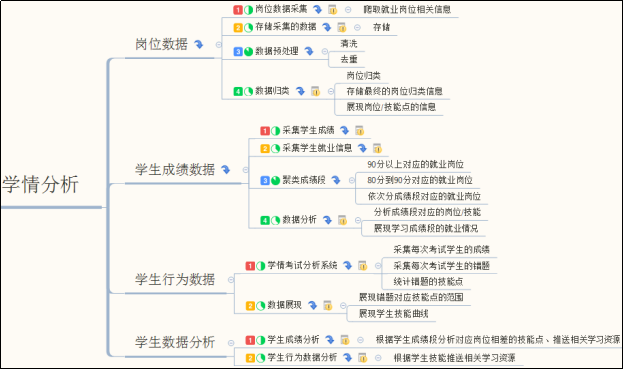

案例构思

实现思路

构建大数据平台

使用Ambari工具构建Hadoop大数据平台,该平台包括HDFS分布式文件系统、MapReduce分布式计算框架、Yarn资源管理器、Hive数据仓库、Mahout数据挖掘工具、Sqoop数据传输工具。

采集岗位信息

借助WebMagic爬虫框架从招聘网站采集就业岗位数据,配置爬虫数据萃取表达式,把采集到的html内容提取出csv格式,数据内容包括岗位、公司、月薪、福利、职位描述、职位要求等。对采集数据进行简单的筛选,保留有价值的信息。

数据存储

HDFS是一个分布式的文件系统,支持海量数据的存储,将采集的数据通过Sqoop传输工具,上传到HDFS文件系统中。

数据处理

MapReduce是一个分布式的并行计算框架,具有高性价比和简单性的优点,MapReduce模型可以将海量任务并行处理,使用该工具可以对数据进行清洗。Hive数据仓库可以将HiveSQL转换成MapReduce任务进行处理,这里可以将数据放在Hive中进行查询和过滤。

数据分析

借助Mahout数据挖掘工具,使用算法库中的K-means文本聚类的方法对岗位信息数据进行分析挖掘,然后将分析结果与学生数据采用向量的相似度算法进行岗位匹配与推荐。

数据可视化

采用电子表格(Excel)与前端开发工具(ECharts,D3.js)将分析结果直观地展现出来。

学情分析系统工程运行

结合Java Web开发框架,将数据采集、数据清洗、数据分析以及数据可视化串联为一个系统,完成一套岗位分析+学情分析的产品DEMO,界面主要用来展示数据可视化结果,设置相应的按钮进行数据计算服务,使用数据库中的数据源进行计算。

返回 Hadoop大数据平台